| Empfehlungen |  |

künstliche neuronale Netze

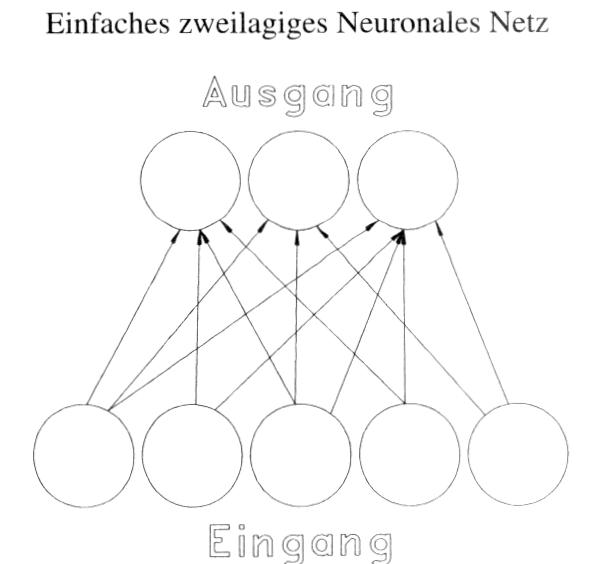

Ein Unit empfängt die Signalinputs aus der Umgebung oder von anderen, vorgelagerten Units, wobei sie über Gewichte modifiziert werden, die als Analogon der biologischen Synapsen zu werten sind. Die gewichteten Eingangssignale werden summiert (dies entspricht der Integrationsfunktion der Zellmembranen), und das Unit »feuert«, falls ein ebenfalls aus der Netzaktivität abgeleiteter Schwellenwert von den aufsummierten Eingangssignalen überschritten wird. Feed-forward- und Feed-back-Netze unterscheiden sich durch die Signalflußrichtung auch in ihren Speicher- und Codierungsfähigkeiten bezügl. der Menge darstellbarer Muster. Unterschiedliche Architekturen (z.B. zweilagige oder mehrlagige) definieren verschiedene Abbildungspotentiale und haben unterschiedliche Konvergenz- bzw. Lerneigenschaften, so dass sich ein künstliches neuronales Netz durch entsprechende Ausgestaltung der Architektur der spezifischen Aufgabenstellung weitgehend plastisch anpassen läßt. Auch dies dürfte im gewissen Sinne eine Nachahmung biologischer Nervensysteme sein. Die Abbildung zeigt eines der einfachsten Feed-forward-Netze, das bereits in der Lage ist, bestimmte Muster zu unterscheiden bzw. in Hardware-Realisation als sog. adaptiver Filter Netzstörungen in einer Telefonleitung zu erkennen und zu unterdrücken. Im ökonomischen Bereich finden vor allem sog. multi-layer perceptrons Anwendung, die zwischen die Eingangs- und Ausgangsschicht zusätzlich mindestens einen sog. hidden layer geschaltet haben. Der Lernvorgang besteht darin, dass die Abweichung des vom künstlichen neuronalen Netz errechneten Outputs mit dem Sollzustand des Ausgangs verglichen und hieraus eine Fehlergröße abgeleitet wird, die schrittweise zur Adaption des künstlichen neuronalen Netzes führt. Hierbei werden die beiden Gewichtsmatrizen Who bzw. Wen, die zwischen hidden layer h und Outputlayer o, bzw. Eingang e und hidden layer h liegen, mit Hilfe der Fehlergröße so lange gezielt verändert, bis alle in der Lernphase angebotenen Eingangsmuster hinreichend präzise in die ihnen zugeordneten Ausgangsmuster abgebildet werden. Dieses Verfahren (es setzt die Verwendung nichtlinearer Aktivierungsfunktionen im hidden layer voraus, sonst degeneriert das dreilagige Netz zu einem faktisch nur zweilagigen) wird Error-Backpropagation genannt. Es wurde 1985 von mehreren Forschergruppen etabliert und führte seitdem zu einem Boom der Forschung und der Anwendungsgebiete. Zu den bereits fest etablierten Anwendungen zählt z.B. die Kredit-Bonitätsprüfung: Nach Eingabe von ca. 2 000 Kreditbearbeitungen inklusive Wertung bzw. Erfahrung, ob der Kredit ordnungsgemäss zurückbezahlt oder notleidend wurde, konnte das Netz die Bonität eines Bewerbers zuverlässiger als die Sachbearbeiter vorhersagen. In der Entwicklungsphase befinden sich derzeit künstliche neuronale Netze, die in der Lage sein sollen, z.B. Aktienkurs-, Devisenkurs- oder kurz- bis mittelfristige Zinssatzentwicklungen aus historischen Zeitreihen derselben und anderer Variablen zu prognostizieren. Zu den hierbei zu lösenden Problemen zählt primär die Frage, unter welchen Bedingungen die in den Inputsignalen enthaltene Information optimal in die Ausgangssignale transformiert werden kann. Literatur: Brause, R. (1991). Stanley, J., Bak, E. (1991). Schöneburg, E. u.a. (1990) Ein Unit empfängt die Signalinputs aus der Umgebung oder von anderen, vorgelagerten Units, wobei sie über Gewichte modifiziert werden, die als Analogon der biologischen Synapsen zu werten sind. Die gewichteten Eingangssignale werden summiert (dies entspricht der Integrationsfunktion der Zellmembranen), und das Unit »feuert«, falls ein ebenfalls aus der Netzaktivität abgeleiteter Schwellenwert von den aufsummierten Eingangssignalen überschritten wird. Feed-forward- und Feed-back-Netze unterscheiden sich durch die Signalflußrichtung auch in ihren Speicher- und Codierungsfähigkeiten bezügl. der Menge darstellbarer Muster. Unterschiedliche Architekturen (z.B. zweilagige oder mehrlagige) definieren verschiedene Abbildungspotentiale und haben unterschiedliche Konvergenz- bzw. Lerneigenschaften, so dass sich ein künstliches neuronales Netz durch entsprechende Ausgestaltung der Architektur der spezifischen Aufgabenstellung weitgehend plastisch anpassen läßt. Auch dies dürfte im gewissen Sinne eine Nachahmung biologischer Nervensysteme sein. Die Abbildung zeigt eines der einfachsten Feed-forward-Netze, das bereits in der Lage ist, bestimmte Muster zu unterscheiden bzw. in Hardware-Realisation als sog. adaptiver Filter Netzstörungen in einer Telefonleitung zu erkennen und zu unterdrücken. Im ökonomischen Bereich finden vor allem sog. multi-layer perceptrons Anwendung, die zwischen die Eingangs- und Ausgangsschicht zusätzlich mindestens einen sog. hidden layer geschaltet haben. Der Lernvorgang besteht darin, dass die Abweichung des vom künstlichen neuronalen Netz errechneten Outputs mit dem Sollzustand des Ausgangs verglichen und hieraus eine Fehlergröße abgeleitet wird, die schrittweise zur Adaption des künstlichen neuronalen Netzes führt. Hierbei werden die beiden Gewichtsmatrizen Who bzw. Wen, die zwischen hidden layer h und Outputlayer o, bzw. Eingang e und hidden layer h liegen, mit Hilfe der Fehlergröße so lange gezielt verändert, bis alle in der Lernphase angebotenen Eingangsmuster hinreichend präzise in die ihnen zugeordneten Ausgangsmuster abgebildet werden. Dieses Verfahren (es setzt die Verwendung nichtlinearer Aktivierungsfunktionen im hidden layer voraus, sonst degeneriert das dreilagige Netz zu einem faktisch nur zweilagigen) wird Error-Backpropagation genannt. Es wurde 1985 von mehreren Forschergruppen etabliert und führte seitdem zu einem Boom der Forschung und der Anwendungsgebiete. Zu den bereits fest etablierten Anwendungen zählt z.B. die Kredit-Bonitätsprüfung: Nach Eingabe von ca. 2 000 Kreditbearbeitungen inklusive Wertung bzw. Erfahrung, ob der Kredit ordnungsgemäss zurückbezahlt oder notleidend wurde, konnte das Netz die Bonität eines Bewerbers zuverlässiger als die Sachbearbeiter vorhersagen. In der Entwicklungsphase befinden sich derzeit künstliche neuronale Netze, die in der Lage sein sollen, z.B. Aktienkurs-, Devisenkurs- oder kurz- bis mittelfristige Zinssatzentwicklungen aus historischen Zeitreihen derselben und anderer Variablen zu prognostizieren. Zu den hierbei zu lösenden Problemen zählt primär die Frage, unter welchen Bedingungen die in den Inputsignalen enthaltene Information optimal in die Ausgangssignale transformiert werden kann. Literatur: Brause, R. (1991). Stanley, J., Bak, E. (1991). Schöneburg, E. u.a. (1990)

Vorhergehender Fachbegriff: Künstliche Intelligenz (KI) | Nächster Fachbegriff: Künstliche Neuronale Netze (KNN) Diesen Artikel der Redaktion als fehlerhaft melden & zur Bearbeitung vormerken |

|

Schreiben Sie sich in unseren kostenlosen Newsletter ein

Bleiben Sie auf dem Laufenden über Neuigkeiten und Aktualisierungen bei unserem Wirtschaftslexikon, indem Sie unseren monatlichen Newsletter empfangen. Garantiert keine Werbung. Jederzeit mit einem Klick abbestellbar.

Weitere Begriffe : loan | Kalkulierte Leerkosten | FDI

|

Praxisnahe Definitionen Nutzen Sie die jeweilige Begriffserklärung bei Ihrer täglichen Arbeit. Jede Definition ist wesentlich umfangreicher angelegt als in einem gewöhnlichen Glossar. |

Fachbegriffe der Volkswirtschaft Die Volkswirtschaftslehre stellt einen Grossteil der Fachtermini vor, die Sie in diesem Lexikon finden werden. Viele Begriffe aus der Finanzwelt stehen im Schnittbereich von Betriebswirtschafts- und Volkswirtschaftslehre. |

Beliebte Artikel Bestimmte Erklärungen und Begriffsdefinitionen erfreuen sich bei unseren Lesern ganz besonderer Beliebtheit. Diese werden mehrmals pro Jahr aktualisiert. |