| Empfehlungen |  |

Informationstheorie

|

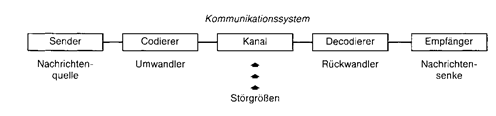

In der Wirtschaftssoziologie: untersucht in enger Beziehung zur Kybernetik Probleme der Informationsvermittlung und der Verarbeitung von Informationen. Hauptbereiche der Informationstheorie sind Fragen der Entwicklung von Zeichensystemen zur Kodierung von Nachrichten (Verschlüsselung - Entschlüsselung) und der Übertragung von Nachrichten in störungsanfälligen Informationskanälen. Neben der Anwendung der statistisch-mathematischen Informationstheorie zur Optimierung technischer Nachrichtensysteme findet die Informationstheorie zunehmend auch Eingang in die Psychologie, Linguistik und Soziologie (z.B. Untersuchung der Wahrnehmungsfähigkeit, der Redundanz sprachlicher Kodes, der „Entropie“ von Gruppenstrukturen). Dabei werden neben der Struktur von Zeichensystemen (Syntaktik) zunehmend auch die Bedeutung der Zeichen (Semantik) und ihre gesellschaftlichen Funktionen (Pragmatik) Gegenstand einer allgemeinen I. wurde 1948 von Claude E. Shannon begründet. Sie versteht sich als ein Teil der Kybernetik. Als eine mathematische Kommunikationstheorie ist sie sehr nachrichtentechnisch orientiert und verwendet sie einen speziellen Informationsbegriff. Informationen werden dabei nur in ihrer syntaktischen Dimension untersucht, ihre Bedeutung ist irrelevant. Der Schwerpunkt der Informationstheorie liegt im Kodieren und Übermitteln von Nach- richten. Sie verwendet dazu Grundlagen aus der Statistik und Wahrscheinlichkeitstheorie. Die Abbildung veranschaulicht die Grundelemente eines Kommunikationssystems. Eine Nachrichtenquelle und -senke verfügen jeweils über einen Vorrat an Zeichen, die Um- und Rückwandler jeweils über einen Vorrat an Signalen. Der Sender bildet aus einer Folge von Zeichen eine Nachricht, die über den Kodierer in physikalisch wahrnehmbare Grössen, in eine Folge von Signalen, umgewandelt und dann über den Kanal übermittelt wird. Die Nachricht wird am anderen Ende des Kanals durch einen Dekodierer in einer dem Empfänger verständlichen Form zurückentschlüsselt. Von besonderer Bedeutung sind dabei die Zeichen- bzw. Signalvorräte des Senders und Empfängers. Zur Bildung bzw. zur Erkennung einer Nachricht muss jeweils eine Auswahlentscheidung aus den Zeichen- und Signalvorräten getroffen werden. In der Informationstheorie werden diese Auswahlentscheidungen als zufällig angesehen. Die Information wird demnach definiert über das Mass an Wahlfreiheit, das man bei der Auswahl einer speziellen Nachricht aus der Menge aller möglichen Nachrichten hat. Das Mass an Wahlfreiheit bei der Auswahl einer Nachricht aus z.B. zwei gleich wahrscheinlichen Nachrichten ist Eins, d.h. die Information ist Eins. Nachrichten, die mit Sicherheit vorhergesagt werden können, liefern demnach keine Information. Als Masseinheit wurde die dimensionslose Einheit bit (binary digit) gewählt.  Ein weiteres Informationsmass ist der mittlere Informationsgehalt einer Nachrichtenquelle. Er wird auch als Entropie der Information bezeichnet und kann als Grad der (beim Empfänger bestehenden) Unsicherheit über die zu erwartende Nachricht verstanden werden. Die Entropie und damit die "Unordnung" sind dann maximal, wenn alle Signale gleich wahrscheinlich sind, so dass der Sender die maximale Wahlfreiheit und der Empfänger die grösste Unsicherheit besitzen. Weitere Theoreme beziehen sich auf die optimale Kodierung einer Nachricht. Bei jeder Kodierung kann Redundanz auftreten. Redundant ist jener Teil einer Nachricht, der ohne Beeinträchtigung des Informationsgehalts weggelassen werden kann. Jede Nachricht lässt sich so kodieren, dass die Redundanz beliebig klein wird. Redundanz vermag jedoch auch dazu genutzt zu werden, die Sicherheit der Nachrichtenübertragung zu gewährleisten, die durch im Kanal auftretende Störungen gefährdet ist. Aufgrund ihrer stark nachrichtenorientierten Sichtweise ist die Anwendbarkeit der Informationstheorie auf wirtschaftswissenschaftliche Problemstellungen sehr eingeschränkt. Ein weiteres Informationsmass ist der mittlere Informationsgehalt einer Nachrichtenquelle. Er wird auch als Entropie der Information bezeichnet und kann als Grad der (beim Empfänger bestehenden) Unsicherheit über die zu erwartende Nachricht verstanden werden. Die Entropie und damit die "Unordnung" sind dann maximal, wenn alle Signale gleich wahrscheinlich sind, so dass der Sender die maximale Wahlfreiheit und der Empfänger die grösste Unsicherheit besitzen. Weitere Theoreme beziehen sich auf die optimale Kodierung einer Nachricht. Bei jeder Kodierung kann Redundanz auftreten. Redundant ist jener Teil einer Nachricht, der ohne Beeinträchtigung des Informationsgehalts weggelassen werden kann. Jede Nachricht lässt sich so kodieren, dass die Redundanz beliebig klein wird. Redundanz vermag jedoch auch dazu genutzt zu werden, die Sicherheit der Nachrichtenübertragung zu gewährleisten, die durch im Kanal auftretende Störungen gefährdet ist. Aufgrund ihrer stark nachrichtenorientierten Sichtweise ist die Anwendbarkeit der Informationstheorie auf wirtschaftswissenschaftliche Problemstellungen sehr eingeschränkt.

Vorhergehender Fachbegriff: Informationstechnologie | Nächster Fachbegriff: Informationsumwelt Diesen Artikel der Redaktion als fehlerhaft melden & zur Bearbeitung vormerken |

|

Schreiben Sie sich in unseren kostenlosen Newsletter ein

Bleiben Sie auf dem Laufenden über Neuigkeiten und Aktualisierungen bei unserem Wirtschaftslexikon, indem Sie unseren monatlichen Newsletter empfangen. Garantiert keine Werbung. Jederzeit mit einem Klick abbestellbar.

Weitere Begriffe : Provider | IEB | Stakeholderansatz

|

Praxisnahe Definitionen Nutzen Sie die jeweilige Begriffserklärung bei Ihrer täglichen Arbeit. Jede Definition ist wesentlich umfangreicher angelegt als in einem gewöhnlichen Glossar. |

Fachbegriffe der Volkswirtschaft Die Volkswirtschaftslehre stellt einen Grossteil der Fachtermini vor, die Sie in diesem Lexikon finden werden. Viele Begriffe aus der Finanzwelt stehen im Schnittbereich von Betriebswirtschafts- und Volkswirtschaftslehre. |

Beliebte Artikel Bestimmte Erklärungen und Begriffsdefinitionen erfreuen sich bei unseren Lesern ganz besonderer Beliebtheit. Diese werden mehrmals pro Jahr aktualisiert. |